AUTOMOBILE - Depuis quelques années, la Silicon Valley nous promet une révolution sur nos routes avec les voitures autonomes, bien plus sures et moins sujettes aux erreurs que nos pauvres cerveaux humains.

AUTOMOBILE - Depuis quelques années, la Silicon Valley nous promet une révolution sur nos routes avec les voitures autonomes, bien plus sures et moins sujettes aux erreurs que nos pauvres cerveaux humains.

Pensez donc: la Google car n'a été responsable que d'un tout petit accident après plus de 2 millions de kilomètres parcourus. Elon Musk affirme que son auto-pilote a réduit les accidents de 50%. La première étude américaine du genre a elle aussi affirmé que les voitures autonomes étaient plus sures que celles conduites par des êtres humains.

Et ce n'est que le début. Les algorithmes qui conduiront dans quelques années nos véhicules seront tellement rapides qu'ils pourront réagir bien plus vite que n'importe qui. Et c'est là que les ennuis commencent et que se pose une question effrayante. Si plusieurs personnes surgissent sur la route et que la seule solution pour les éviter est de se jeter contre un mur, tuant ainsi le conducteur, la voiture devra-t-elle faire ce choix?

Une équipe de chercheurs franco-américaine publie justement une étude à ce sujet, jeudi 23 juin dans la revue Science. Ils ont interrogé près de 2000 personnes et leur ont demandé leur point de vue sur cette question morale. Ils ne s'attendaient pas vraiment à ces résultats, qui vont poser un vrai dilemme à notre société dans les années à venir.

Le sens du sacrifice

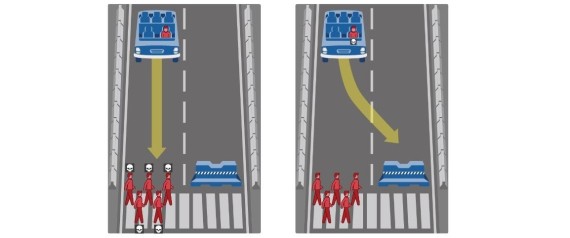

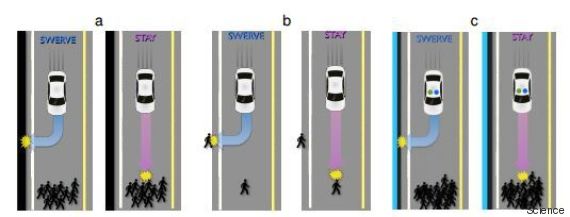

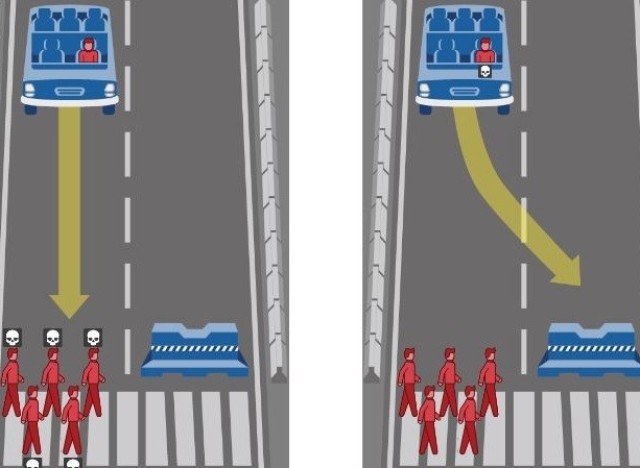

Jean-François Bonnefon, directeur de recherche au CNRS et ses deux collègues Azim Shariff et Iyad Rahwan, ont donc mis les sondés devant plusieurs scénarios. Par exemple, une voiture autonome doit choisir entre tuer plusieurs piétons ou le conducteur, tuer un piéton ou le conducteur ou encore choisir de faire une embardée pour sauver des piétons, mais en tuer un dans le mouvement.

Des questions qui font clairement penser au dilemme du tramway. Dans cette expérience de psychologie, un tramway s'engage sur une voie à travers un canyon où se trouve un groupe de cinq personnes. Le tramway n'a pas le temps de freiner. Mais vous avez la possibilité d'actionner un bouton pour changer l'aiguillage et envoyer le véhicule sur une voie similaire où une seule personne se trouve. Ce dilemme philosophique (plus d'informations ici) est censé positionner les gens entre éthiques utilitariste (la fin justifie les moyens) et déontologique (ce choix est immoral par principe).

Si environ neuf personnes sur dix choisissent de sacrifier une personne pour en sauver cinq, elles sont bien moins nombreuses (38%) quand le seul moyen d'arrêter le tramway est de pousser un homme obèse sur la voie. Et quand c'est à une voiture de faire ce choix? Selon les chercheurs, la majorité des sondés pensent que l'algorithme doit être conçu dans une logique utilitariste et doit donc sacrifier son conducteur pour sauver plusieurs personnes (plus elles sont nombreuses, plus les sondés sont d'accord).

Mourir pour des idées, d'accord, mais de mort lente

Tant d'altruisme, c'est beau. Enfin, tant que le conducteur, c'est l'autre. Car quand les chercheurs ont demandé aux sondés s'ils achèteraient une voiture autonome programmée pour sacrifier le passager afin de sauver le plus grand nombre, les réponses étaient en grande majorité négatives.

Bref, d'accord pour que les voitures autonomes soient le plus sures possibles, quitte à devoir, dans des cas extrêmes, sacrifier le conducteur, mais ne comptez pas sur moi pour l'acheter. "C'est la signature classique d'un dilemme social dans lequel chacun a la tentation de la facilité plutôt que d'adopter un comportement positif pour le bien commun", notent les chercheurs.

Il faut reconnaître que "c'est une idée terrifiante, de posséder un objet programmé pour nous tuer. Il n'y a pas de précédent", explique au HuffPost l'auteur de l'étude Jean-François Bonnefon, professeur à l'école d'économie de Toulouse. Par contre, les économistes connaissent bien ce genre de dilemme. C'est un peu comme pour les impôts: tout le monde trouve ça bien pour le pays, mais beaucoup essayent de ne pas en payer.

Dilemme d'État

La solution semble donc toute simple. Comme pour les impôts, c'est à l'État d'imposer une régulation aux constructeurs pour le bien commun. Sauf que les personnes interrogées sont plutôt opposées à ce que l'État oblige les voitures autonomes à sacrifier leur conducteur. Bien sûr, un gouvernement pourrait choisir une mesure, certes impopulaire, mais nécessaire.

Mais quand bien même, "une législation pourrait être contre-productive, car si les gens n'achètent pas de véhicules autonomes et continuent à conduire leurs vieilles voitures, il y aura plus de morts", note Jean-François Bonnefon. Dans ce cas-là, faut-il donc imposer une loi pour gérer des cas qui seront extrêmement rares? "Si on ne le fait pas, il y aura un trou dans le code de l'algorithme, et que fera alors la voiture si cela arrive?", interroge Jean-François Bonnefon. Et l'autre solution, qui consiste à laisser les constructeurs choisir, n'est pas très reluisante non plus. On imagine déjà les publicités "notre voiture vous protège même à un contre dix!".

Surtout, les choix à trancher seront beaucoup plus compliqués et ne seront jamais aussi binaires que le dilemme du tramway. "Faut-il compter pour deux une femme enceinte?", demande le chercheur. De même, la voiture aura-t-elle à prendre en compte le risque de mourir pour chaque personne et à pondérer ainsi son jugement?

Suite à cette étude, les auteurs ont mis en ligne un site qui permet justement aux internautes de se positionner sur des dilemmes encore plus tordus, voire même d'en inventer de nouveaux.

Faut-il mieux sauver des enfants que des personnes âgées, etc. Des questions qui donnent la chair de poule. Mais auxquelles nous n'auront peut-être pas à donner de réponse définitive. Comme le notait le site Vox en s'interrogeant sur cette effrayante question la semaine passée, les décisions morales doivent théoriquement être prises avec sagesse, clairvoyance et maîtrise de soi.

Or, l'intelligence artificielle devrait bien s'en sortir sur ces trois domaines. Comme cette technologie fonctionne grâce au deep learning, ce principe qui permet à une machine d'apprendre par l'exemple, il est possible que nous n'ayons pas à lui donner des instructions claires sur toutes les situations possibles. Mais plutôt une consigne générale, comme "tu ne dois pas blesser une personne", à laquelle l'algorithme tentera de répondre au mieux grâce à ses millions de données analysées en temps réel, ses dizaines de capteurs et ses réflexes surhumains.

Ainsi, les véhicules autonomes pourraient peut-être empêcher le dilemme du tramway de se produire, en conduisant mieux à la source, espère Vox. Mais quand on sait qu'aux Etats-Unis, plus de 3200 milliards de kilomètres sont parcourus chaque année, difficile de se dire que l'impossible ne se produira pas. Il faudra alors espérer que la manière dont l'algorithme interprétera la consigne qui lui a été donnée nous conviendra.

Une idée qui fait furieusement penser aux trois lois de la robotique, imaginées par l'écrivain de science-fiction Isaac Asimov et censées encadrer les robots avec des devoirs moraux symbolisés par trois lois (se protéger, obéir aux humains et, surtout, les protéger). Au fil des années, l'écrivain interrogea ces lois, les poussant dans leurs limites et imaginant finalement une loi zéro affirmant que la protection de l'humanité prévalait sur la protection de l'individu. Un choix clairement utilitariste et dont les conséquences furent notamment la destruction de la Terre, seule solution pour que l'espèce humaine survive en s'étendant dans l'espace. Espérons que nos machines ne se retrouveront pas face à cet extrême dilemme du tramway avant des siècles.

Lire aussi :

• Comment les voitures autonomes pourraient révolutionner les routes et rendre les villes aux piétons

Source : Les voitures autonomes devraient sacrifier leur conducteur pour sauver des passants, mais...

Avis Pimpf : autant sur le choix d'un humain on pourrait le critiquer car il perd le contrôle du véhicule , mais demain quand ce sera piloté par un automate et des programmes ce sera la faute de qui ? du constructeur ? du logiciel ? Encore un grand dilemme.

Aucun commentaire:

Enregistrer un commentaire